グーグルやマイクロソフトなどIT各社が表明 AI倫理を確認することの重要性

AIに関してIT各社が倫理を規定しています。「AIは危険」という脅威論も根強くある中で、倫理的な評価を確認しておくことが、AI活用の前提条件となってきます。既に生活のあらゆる場面にAIが浸透しており、導入期の警戒感も薄れてきているのも実情です。だからこそ、今一度AIとの付き合い方を根本から考えておきたいところです。

日本だけでなく、米国を含めた世界がAIをどのようにとらえているのかを理解することが、結果として、AIを活用してビジネスで成功することにつながると考えられます。

ここでは、米Stanford大学、Google、Microsoft、IBMといった学術機関と主要IT企業のAI倫理を参照し、日本での動きも確認した上で、今後のAI利用を展望します。

Stanford大学の考え方

Stanford大学は「Stanford哲学百科事典(SEP)」の中で、AIを含めたテクノロジー動向について、最新の状況を報告しています。それによると、AIとロボット工学の倫理は、多くの場合さまざまな種類の「懸念」に焦点を当てています。これは、新しいテクノロジーへの典型的な対応だといいます。特に重要と考えられるのが、AIベースで構築されたシステムが「不透明」であることです。

「多くのAIシステムは“正しい”ソリューションが提供されているかどうかに関係なく、特定のデータセットからパターンを抽出する(シミュレートされた)ニューラルネットワークの機械学習技術に依存しています」とSEPは指摘します。

これらの手法では、「学習」によってデータのパターンがキャプチャされ、システムによる意思決定に資する方法でラベルが付けられます。しかし、プログラマーは実際にどのパターンが使用されて意思決定に至ったかを知ることができません。

さらに、運用していくうちにプログラムは進化していき、新しいデータが入ってきたり、何が正しかった、正しくなかったといった新しいフィードバックが与えられたりしながら、学習システムで使用されるパターンは変化していきます。

「つまり、これはAIが導き出す結果は、プログラマーにとって、もちろんユーザーにとっても透過的なものではなく、不透明なものであることを意味している」とスタンフォード大学が指摘しているのです。

さらに、「プログラムの品質は“ガベージイン、ガベージアウト”(ゴミからはゴミしか生まれない)という古いスローガンに従い、提供されるデータの品質に大きく依存」(SEP)します。結果として、データにすでに偏見が含まれている場合、AIプログラムはその偏見を再現してしまうわけです。

以前、米IT企業が提供するツールを利用して、犯罪者の顔写真2500枚を米連邦議会議員の顔写真と比較したテストで、非白人は全議員の20%しか占めていないにもかかわらず。誤認識された米議員の約40%は非白人だったことが問題になりました。

これにより、人権擁護団体やIT企業の一部が、顔認識技術の普及により、人種的マイノリティーが不利益をこうむるとの懸念を示しました。顔認識技術は、iPhoneやAndroidスマートフォンで使われ、警察、小売店、空港、学校なども採用しつつあるため、米国で議論を呼んだのです。

米国におけるAI利用のニュアンスが見えてきたところで、米IT大手の指針を確認しておきましょう。ここではGoogle、Microsoft、IBMの考えを確認します。

米IT企業の指針

Googleは、AI利用における7つの基本方針について説明しています。社会にとって有益であること、不公平なバイアスの発生や助長を防ぐ、安全性確保を念頭においた開発と試験、人々への説明責任を果たせるように人間によるコントロール下に置く、プライバシー・デザイン原則の適用、科学的卓越性の探求、これらの基本理念に沿った利用への技術提供という7つです。

一方、次のような分野ではAIの設計や提供をしないとしています。それは、総合的に見て有害または有害な可能性があるテクノロジー、人々に危害を与えるまたは人々への危害の直接的な助長を主目的とした武器またはその他の技術、国際的に認められた規範に反するような監視のために情報を収集、利用するためのテクノロジー、広く一般的に認められた国際法の理念や人権に反する用途のための技術などです。

Microsoft

Microsoftも、人を第一に考える倫理原則に基づいてAIの発展に取り組むとして、指針と組織を公表しています。「Microsoftは、ORA(責任あるAIオフィス)、Aether(AI、倫理、およびエンジニアリングと研究における効果)委員会、RAISE(エンジニアリングにおける責任あるAI戦略)を通じて、責任あるAIの原則を実践します。Aether委員会は、AIイノベーションによってもたらされる課題や機会について、リーダーに助言を行います。ORAは、Microsoftのルールとガバナンスプロセスを設定し、会社全体にわたるチームと緊密に協力して取り組みを進めています。RAISEは、エンジニアリンググループ全体でMicrosoftの責任あるAIルールの実装を可能にするチームです。

IBM

IBMは「あらゆるアルゴリズムにおいて公平性と透明性を確保する」というAI倫理に対するアプローチを表明しています。IBMは次のように述べています。

「AIは、日常生活、ビジネス、行政、医療などに取り入れられています。人や企業によるAIの導入を支援することはIBMの責務です。私たちは、AIアプリケーションやプロセスに倫理原則を組み込むことによって初めて、信頼に基づくシステムを構築できます」

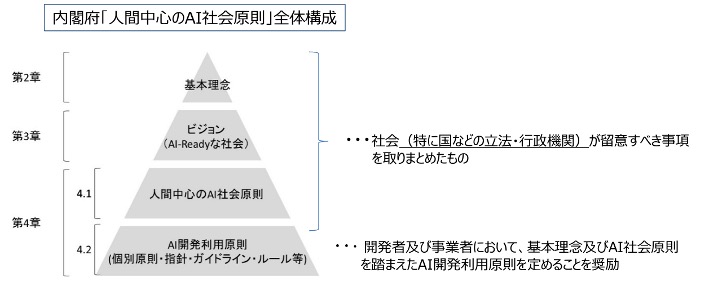

日本では内閣府が「人間中心のAI社会原則検討会議」設置

日本では2018年5月、内閣府が「人間中心のAI社会原則検討会議」を設置し、2019年2月から「人間中心のAI社会原則会議」に移行しました。産学民官のマルチステークホルダーにより、AIをより良い形で社会実装し、共有するための基本原則となる「人間中心のAI社会原則」について検討します。人間中心のAI社会原則は、社会、特に国などの立法・行政機関が留意すべき原則をまとめたものです。

総務省における議論で用いられた資料

人間中心のAI社会原則は、社会がAIを受け入れ適正に利用するため、社会が留意すべき基本となる以下7原則を示したものです。

人間中心の原則

AIは、人間の労働の一部を代替するのみならず、高度な道具として人間の仕事を補助することにより、人間の能力や創造性を拡大することができる。

教育・リテラシーの原則

人々の格差やAI弱者を生み出さないために、幼児教育や初等中等教育において幅広く機会が提供されるほか、社会人や高齢者の学び直しの機会の提供が求められる。

プライバシー確保の原則

パーソナルデータを利用したAI、およびそのAIを活用したサービス・ソリューションは、政府における利用を含め、個人の自由、尊厳、平等が侵害されないようにすべきである。

セキュリティ確保の原則

社会は、AIの利用におけるリスクの正しい評価や、リスクを低減するための研究など、AIに関わる層の厚い研究開発を推進し、サイバーセキュリティの確保を含むリスク管理のための取組を進めなければならない。

公正競争確保の原則

特定の国にAIに関する資源が集中することにより、その支配的な地位を利用した不当なデータの収集や主権の侵害が行われる社会であってはならない。

公平性、説明責任、及び透明性(FAT)の原則

AIの設計思想の下において、人々がその人種、性別、国籍、年齢、政治的信念、宗教などの多様なバックグラウンドを理由に不当な差別をされることなく、全ての人々が公平に扱われなければならない。

イノベーションの原則

Society 5.0を実現し、AIの発展によって、人も併せて進化していくような継続的なイノベーションを目指すため、国境や産学官民、人種、性別、国籍、年齢、政治的信念、宗教等の垣根を越えて、幅広い知識、視点、発想等に基づき、人材・研究の両面から、徹底的な国際化・多様化と産学官民連携を推進するべきである。

国がAIについてこのような立場を表明していることに加え、各IT企業も施策を発表しています。富士通は2019年3月に「富士通グループAIコミットメント」を策定し、公表しています。

「AIの安心・安全な利用に向けて、AI関連の技術やソリューション・サービスの研究開発・提供に際し、AI倫理を含む価値観をまとめたものとして富士通グループAIコミットメントを策定しています。外部の有識者等で構成される委員会を設置し、その客観的な評価を取締役会と共有することで、AI倫理に関するコーポレート・ガバナンスの充実を図るとしたものです」

NECも同時期である2019年4月、「AIと人権に関するポリシー」を策定し、公表しました。AIの社会実装や生体情報をはじめとするデータの利活用において、プライバシーへの配慮や人権の尊重を最優先して、事業活動を推進するための指針を策定しています。

各社員が、企業活動の全ての段階において人権の尊重を常に最優先なものとして念頭に置き、それを行動に結びつける指針として、公平性、プライバシー、透明性、説明する責任、適正利用、AIの発展と人材育成、マルチステークホルダーとの対話の7つを掲げました。

AIの潜在的で典型的な課題は「事故の責任を誰が取るのか」

欧州委員会は2021 年 4 月 21 日に「Proposal for a Regulation laying down harmonised rules on artificial intelligence (Artificial Intelligence Act)」を発表しました。EU 市場で利用されるAIシステムが、安全で、基本権及びEUの価値観に関する既存の法令を尊重したものとなることを確保することなどを目的として提案されたものです。米国、日本だけでなく、欧州も含めて、世界中でAIの課題が持ち上がっていることが分かります。

そのAIの課題として、最もわかりやすいものがあります。それが事故の責任問題です。「AIが起こした問題の責任は誰がとるのか」です。理屈として、責任者として考えられるのは、AIのユーザーと製造者です。まず、AIユーザーが負う可能性があるのが不法行為責任だと言われていますが、実際には故意または過失があること、損害が発生していることなどいくつかの条件がそろっている必要があります。

いずれにしても、AIが起こした事故の責任問題は、AIの産業利用において非常に大きな問題と言えるでしょう。自動運転車にしても、交通事故の責任の所在がわからないのでは、実利用にはかなりの制限がかかってしまうでしょう。さまざまな業種で、AI活用の際に、責任に関する同様の問題が起きると考えられます。

やはり、膨大な可能性を持ちながらも、AI利用において突き詰めていくと、どうしても倫理問題がひっかかってくることが見えてきます。利便性と倫理的側面という諸刃の剣として、AIは今後もしばらくは慎重さを伴いながら、それでも着実に前に進んで行くと考えられます。

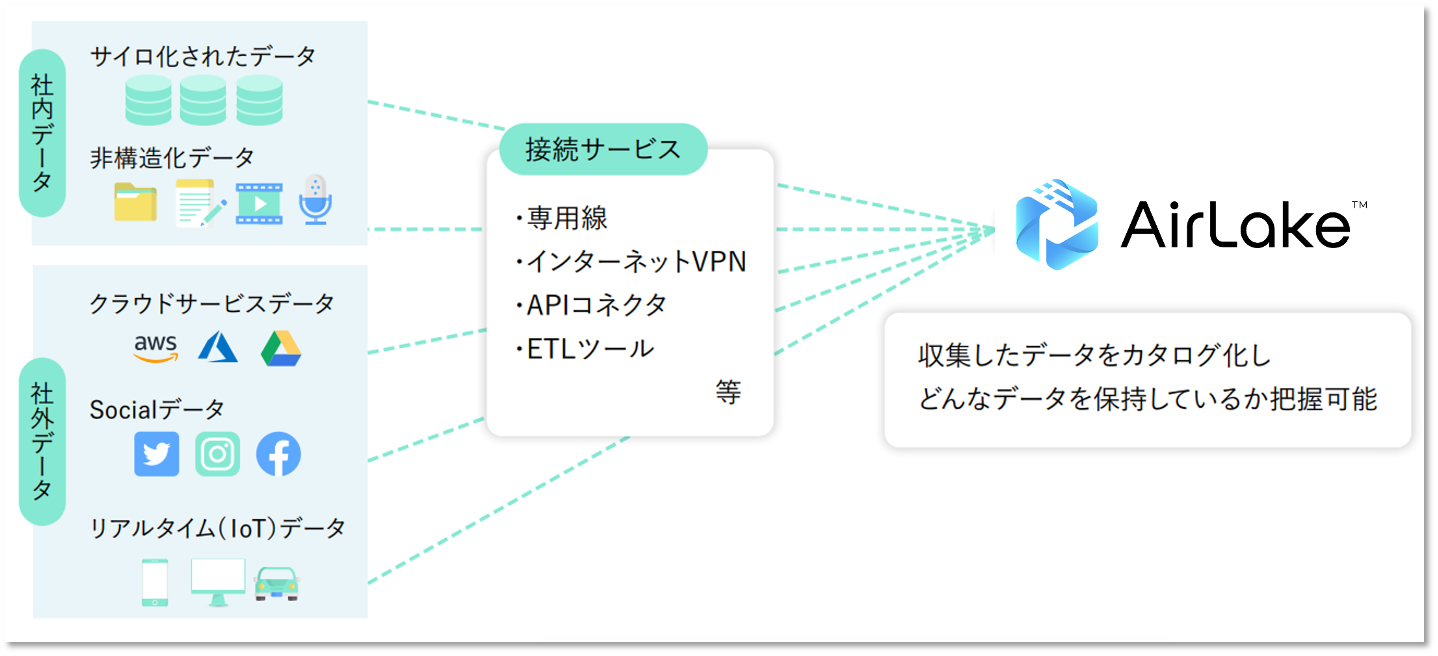

誰でも簡単に

「社内外のデータ収集」と

「非構造化データの構造化」で

データを資産化

AirLakeは、データ活用の機会と効果を拡張する

ノーコードクラウドデータプラットフォームです。